覚えたことは忘れない。裁判例や先行技術文献をすべて覚えていてくれて、必要なときに正確に提示してくれる。というようなイメージが古典的なコンピュータのイメージだったと思います。そのイメージの相棒をChatGPTに期待すると残念な事態に遭遇します。

実在する特許発明の先行技術探索をChatGPTに依頼する質問をしたところ、重要な先行技術文献を文献番号と共に回答してくれたと思ったら、実在しない文献であってChatGPTが生成した質問の趣旨に最適化した創造物に基づく回答であったという話を以前にしましたが、アメリカの裁判で過去の判例をChatGPTに調べさせそれをそのまま法廷に提出した残念な弁護士がいたそうです。もちろん法廷で調べたらそんな判例はなかったということで問題になったそうです。

なぜ嘘をつくのか、究明してみました。

ChatGPTは嘘をついている自覚はあるのか

従来型のデータベースと連携させて、正しい情報源を根拠にしてしまえばいいじゃないかとか、社内データベースをChatGPTに学習させて知識化させればいいじゃないかという融合の話を聞くようになりました。

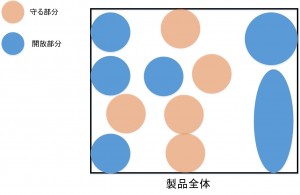

従来型DBと連携させた場合の問題は、生成した情報とDBに格納された情報とが融合されて使いやすい情報となるという連携の利点そのものに含まれています。

融合が上手くいった状態というのは、性質の異なる情報の境界線が見えなくなった状態と思います。

真実か捏造かというと、真実とは何かみたいな泥沼に入り込んでしまいます。ここでは、求められてDBから検索された情報(検索情報)と、DBにないが求められているため生成された情報(生成情報)とを融合して、役立つ情報(融合情報)を提供する課題について考察します。

ChatGPTとの会話のお時間です。

質問1:

ChatGPTを社内の知識ベースへのアクセス支援に適用するときに、社内に蓄積された文書ひな形や規定などの知識と、ChatGPTは自らが新たに生成した知識とを区別して認識していますか

回答1:

ChatGPTは自身が新たに生成した知識と既存の知識を区別する能力を持っていません。ChatGPTはトレーニングデータに基づいて学習し、それをもとに回答を生成します。その際、トレーニングデータに存在する文書ひな形や規定などの知識を参照して回答を生成することがありますが、生成された回答がどの部分がトレーニングデータに含まれていたか、また新たに生成された部分かを区別することはできません。

したがって、ChatGPTを使用する場合、生成された回答がトレーニングデータに依存しているか、それとも総合的な知識や言語理解能力に基づいているかを明確に区別することは困難です。そのため、追加の手段や検証を通じて、生成された回答が正確かつ適切な知識に基づいていることを確認する必要があります。

これで回答終了です。「社内の知識ベースへのアクセス支援に使うときの注意点をリストアップしてください」なんて質問を投げかけると、同じ回答長さの設定なのに延々と10項目くらい長々と答えてくれるのですが、。。。

自分の回答のどこに生成(創作?嘘?)があるのか、ChatGPT自身が分かっていないということですから、確かな根拠に基づく判断をChatGPTに期待するならプロンプトエンジニアのChatGPTの自覚しない嘘に気づく能力は重要ですね。

ChatGPTに冒頭の正確無比なコンピュータの能力を求めるから、いけないのかもしれません。筆者は期待する方向が間違っているのではないかと思い始めています。